Claude Bailblé

Dès la seconde moitié du XIXe siècle, la photographie capte et enregistre (presque en instantané) la vie « en direct ». Au tournant du siècle, les opérateurs de cinéma, munis de caméras portables, ramènent des vues noires et blanches de tous les continents. Ne manque donc que le son pour que l’observation soit complète, pour que le témoignage soit entier. Il faut cependant attendre le début des années soixante, et ses innovations techniques — comme le magnétophone portatif, ou la caméra portable, autosilencieuse — pour ajouter une perspective sonore à la perspective visuelle. Pour enregistrer la vie « telle qu’elle se présente » à nos sens, ici et là-bas, sans mise en scène ni post-synchronisation. Le 16 mm et la bande lisse 6,25 mm offrent alors des supports commodes à l’enregistrement simultané de l’auditif et du visuel. L’alimentation basse-tension des appareils (enfin transistorisés) autorise l’emploi de batteries ou de piles peu encombrantes, allégées, et donc aisément transportables. La saisie des images et des sons par des opérateurs « tous-terrains », paraît pour la première fois accessible.

Non sans difficultés. Car le microphone paraît bien fruste ou bien peu discret, lorsqu’on le compare à la performance d’un objectif. Sans précautions instrumentales rigoureuses, l’enregistrement paraîtrait brouillé, envahi, voire surchargé de sons indésirables. Mais quel résultat ! Omnidirectionnelle ou presque, la captation du monde sonore semble « authentique » : elle ne délimite pas un cadre, une pyramide visuelle, elle ne refoule pas un hors-champ. Pour le preneur de sons, en effet, tout est « dans le champ » ! Le microphone restitue le lieu en son entier, sans dissimulation, ni focalisation. Le son ajoute ainsi à la « fenêtre visuelle » une « façade » beaucoup plus large, une présence spatiale renforcée, et même une différenciation efficace entre l’actif (bruissant) et l’inactif (silencieux). En sorte que l’image se trouve délivrée de sa prison rectangulaire comme de son mutisme originaire. Le « cinéma direct », et son cortège d’illusions réalistes va donc – pour un temps — pouvoir se déployer, médusé sans doute par les possibilités expressives d’une captation à la fois visuelle et auditive.

Le « réel » peut se donner en longs plans-séquences non « montés » (les dix minutes d’un chargeur de caméra) augmentés d’un son rigoureusement synchrone. Le microphone en avant, la caméra à l’épaule, le cinéaste s’illustre alors comme chercheur et témoin d’une parole jusqu’alors inaccessible, une parole spontanée, vivante, loin des studios et des décors factices. La société entière devient brusquement le théâtre d’une nouvelle captation, celle de la vérité des situations et des personnes, vérité saisie sans fard ni préparation, au détour d’une opportunité ou d’un forcing de questions. Captation essentiellement micro-phonique, authentifiée par le gros plan et validée par le refus de la coupe et du montage. Cinéma-vérité, en quelque sorte. Le portrait parlé (sur le vif) domine alors les films voués à cette entreprise.

Cependant, et assez vite, la nouveauté du procédé s’épuise. Le documentaire se lasse des improvisations de la parole, aussi pertinentes ou émouvantes soient-elles. Les cinéastes en reviennent au cinéma, tandis que les reporters s’en vont au reportage, à l’interview Bétacam (soit, assez souvent, à l’expéditif : « prenons, couvrons, on verra au montage »). On ne pouvait évidemment s’aveugler très longtemps sur les performances des nouveaux outils, en leur demandant l’impossible : confondre le réel d’une « saisie » audio-visuelle – aussi facilitée soit-elle – avec la restitution audio-visuelle du réel 1.

Il n’empêche. Nombre de cinéastes cherchent encore aujourd’hui à rendre un son « naturel », proche de l’écoute attentive, à savoir : un son focalisé vers la source intéressante, et simultanément désencombré des bruits ambiants, triviaux ou inopportuns. Ou, si l’on veut, une intelligibilité accrue de ce que l’on veut écouter, et en même temps, une mise en sourdine — sous forme de bruit de fond peu gênant, quasi-insignifiant — des autres émetteurs sonores.

De fait, si l’on ne confond plus guère le plan-séquence avec le réel, on a pourtant encore besoin d’un son intelligible — c’est bien le minimum ! — quel que soit son devenir lors du montage ou du mixage. Mais comme on a pris le parti d’effacer les outils de la captation, de reléguer la technique (perches et micros) dans le hors-champ image(2), l’obtention d’un son « naturel » devient presque impossible, pour cause d’éloignement microphonique. Tandis que l’objectif procède à un véritable « découpage » du monde visuel, le microphone n’opère qu’un « ramassage » à peine orienté du monde sonore. C’est pourquoi le perchman, voulant retrouver l’écoute directionnelle sélective, doit travailler au plus près des sources, dans la mesure où l’intelligibilité ne peut être obtenue que par rapprochement du capteur, seule façon d’avantager le son émis, notamment en ambiance bruyante. Le cadrage-son, à l’inverse du cadrage-image, semble obéir aux contraintes acoustiques.

Ainsi, dans le cinéma direct, le gros plan est plus souvent une commodité de prise de sons (le micro bien rapproché reste hors-champ) qu’un choix délibéré de mise en scène. On est donc bien loin de l’improvisation, de la « saisie focalisante et discrète » (aussi discrète qu’une paire d’oreilles peut l’être), ou d’un enregistrement « transparent » des réalités sonores.

L’avatar monophonique

Que restitue au juste le microphone : une aire sonore, une perspective omnidirectionnelle, un mélange acoustique entièrement dépendant de la force ou de la douceur des sons, de la proximité ou de l’éloignement des sources à l’entour. Un mixage passif des intensités et des distances, non retravaillé par la faculté auditive, faculté qui isole et exhausse l’objet de l’attention tout en laissant dans l’ombre les bruits environnants. Ce que nous entendons est en effet fortement polarisé, même si nous n’en avons pas conscience. Le cadrage auditif structure un rapport figure sur fond, organisant une discrimination entre la zone écoutée (contourée et nette) et son alentour (amorphe et flou), vaguement entendu. Les sons inintéressants sont passablement filtrés, amoindris. L’intelligibilité est ainsi acquise, même en milieu bruyant. Tandis qu’un microphone tel que le cardioïde, en sélectionnant au mieux l’espace frontal — sans faire dans le détail — ramène un son épais, encombré, et souvent assez peu intelligible.

Le cinéma classique s’est affranchi de la difficulté en pratiquant la prise de son fractionnée : la perche (qui rapproche le capteur de la source) enregistre tout d’abord les voix dans des locaux spécialement traités (qui abrègent la réverbération). Les sons seuls, les bruits, les ambiances sont par ailleurs enregistrés séparément, les uns après les autres, sur fond silencieux, à la distance optimale. D’autres bruitages sont ajoutés, en post-synchro. De nombreuses bandes ou pistes sont alors nécessaires, si l’on souhaite doser séparément le poids de chacun des sons, sans en modifier simultanément un autre. Le montage-son sépare et prépare chacun d’entre eux pour le mixage final. Les potentiomètres reconstituent alors -par mélange électrique-l’étagement des différents plans sonores, l’estompage auditif, la structuration figure/fond. L’impression de réalité est donc entièrement recomposée par la surimpression pondérée des différents éléments sonores.

Le cinéma direct n’offre évidemment pas les mêmes possibilités : le microphone y absorbe toute la rumeur du monde. On ne peut réclamer le silence sur le grand plateau du « réel » ! Que recueille-t-on sans précautions ? Un son « brut », peu familier, empâté de réverbération excessive ou de brouhahas intempestifs, un son brouillé par les éclats des autres sons, un son englué et peu défini. Le monde sonore restitué par le casque semble aussi artificiel, aussi peu « réaliste » que possible. Le fameux « son direct » serait-il si difficile à maîtriser ?

On a souvent reproché au microphone de ne pas savoir cadrer, comme l’appareil auditif, de ne pouvoir focaliser sur la source écoutée en atténuant convenablement les sons environnants. Il faut plutôt interroger le dispositif monophonique, dispositif qui comprime l’espace, le donne à entendre par un projecteur hublot, en un goulot d’étranglement où viennent — pêle-mêle — se superposer les sons, désormais confondus en un seul point d’émission : le haut-parleur. Un tel dispositif réduit l’espace à une seule dimension, celle de la profondeur. La hauteur et la largeur de champ sont artificiellement supprimées, aussi bien lors de la captation (image-point microphonique), que lors de la restitution (haut-parleur quasi-ponctuel). De sorte que l’appareil auditif, habitué à traiter les ondes de diverses provenances différemment reçues par les deux tympans, se trouve confronté soudain à une information unique (monophonie), identiquement reçue à gauche et à droite. Cette disposition semble ignorer le pourquoi des deux oreilles.

Les différences intéraurales (différences d’intensité Al, différences de temps AT) si importantes dans la latéralisation des sons, si indispensables dans la constitution de l’espace auditif, ont disparu. Ne subsiste qu’une perspective de profondeur, en laquelle se bousculent tous les événements sonores, en une sorte de surimpression opacifiante.

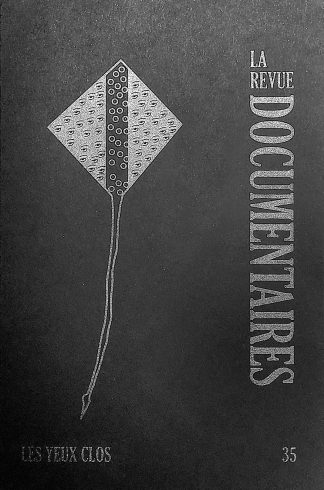

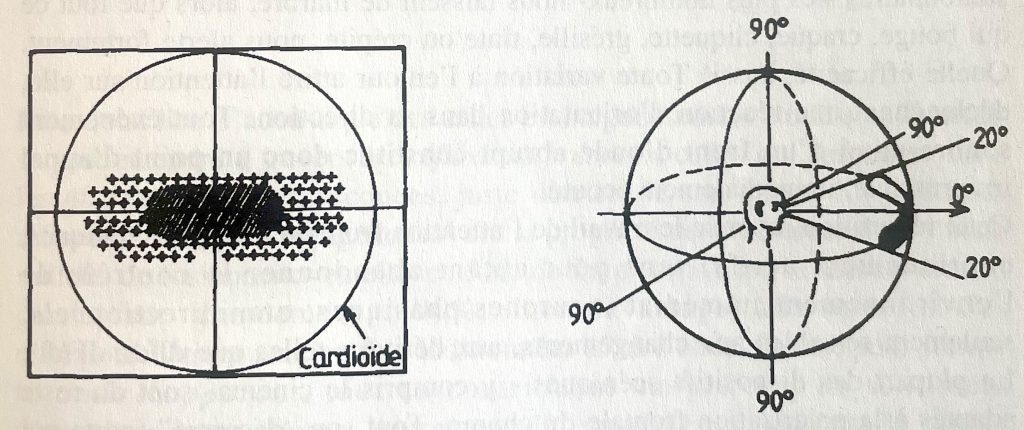

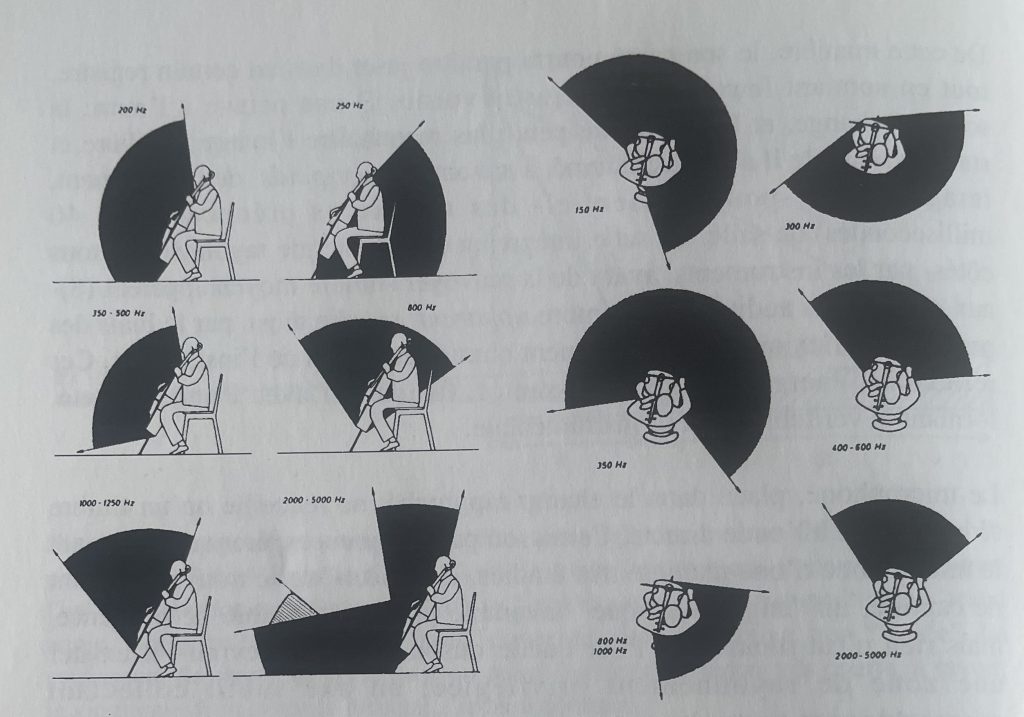

Figure 1

L’oreille directionnelle

L’oreille externe capte différemment les sons selon leur provenance : les aiguës sont particulièrement affectés par l’azimut des sources.

La réverbération, l’ambiance des lieux, les bruits adjacents s’agglomèrent en un même point d’émission, se recouvrant les uns les autres. Espace borgne, écoutille aveugle, haut-parleur hublot. L’écoute sélective, directionnelle, est anéantie. Impossible de trier, de démêler, de séparer ou isoler un son. Tout se recouvre, tout se superpose. L’audibilité est fortement entamée. Ainsi, une acoustique naturelle et légère, si plaisante d’ordinaire, en vient à masquer la clarté des sons. L’espace bizarrement rétréci semble surgir d’un tunnel.

Autant dire que sans précautions instrumentales draconiennes, la monophonie est tout simplement inaudible.

Dès les débuts de l’enregistrement sonore, on a recherché les procédures instrumentales susceptibles de contrer les effets réducteurs du tunnel monophonique, lesquels endommagent trop fortement la perceptibilité relative des sons. L’impression de réalité, l’analogon auditif doivent être restaurés.

C’est ainsi qu’à la radio, on approche les micros des sources vocales, afin d’éliminer l’imprécision, le brouillard d’une captation naïve, faite à distance ordinaire, à distance habituelle : celle de l’écoute directe. L’intelligibilité du texte parlé prime en effet sur l’exactitude du timbre. L’emplacement microphonique est donc dicté par la netteté de la voix. En approchant le capteur, on favorise la source, on défavorise la réverbération du local. L’espace est détruit, le timbre est transformé, mais la compréhension est sauve.

Lors des enregistrements musicaux, l’intelligibilité est moins sévère, mais les sources synchrones se multiplient. Elles peuvent donc se masquer ou se recouvrir les unes les autres, jusqu’à perturber la lisibilité musicale. Les instruments, convenablement orientés, sont d’abord disposés en demi-cercle autour de l’unique capteur. Certains instruments paraissent grossis par le microphone, d’autres s’amenuisent à la limite de l’audible, ou s’auréolent d’une réverbération excessive. L’étagement des intensités et des plans sonores est alors réglé par l’éloignement judicieux des différents pupitres. Selon la force et le timbre des instruments, de nombreux ajustements seront nécessaires quant à l’emplacement des musiciens, si l’on veut donner une image approchant celle que l’on entend en concert. Il faut redisposer l’orchestre, tout en ménageant l’écoute des instrumentistes, qui doivent continuer de s’entendre afin de jouer ensemble. Une certaine « aération » est tout de même possible : on profite de l’acoustique de la salle ou de l’auditorium.

Par la suite, pour augmenter la netteté sonore, on implantera plusieurs microphones, en réglant la distance et l’axe de chacun d’entre eux, au regard des solistes ou des groupes instrumentaux. Ce ne sont plus les musiciens que l’on dispose devant l’unique capteur, mais plutôt les différents micros que l’on approche des instrumentistes. À charge pour le mixeur d’établir la balance adéquate, de restaurer la lisibilité musicale. Tout cela suppose que l’enregistrement de proximité donne à la fois le bon timbre et la bonne netteté sonore. Comme s’il existait un point de capture optimal, apte à saisir en même temps le contour précis et la sonorité exacte de l’instrument. 3

Au cinéma, la mise hors-champ du micro impose un éloignement du capteur peu compatible avec les exigences de l’intelligibilité. Capter les consonnes, les articulations de la voix, les soupirs, les respirations, suppose une certaine proximité. Certes, une voix bien posée, bien articulée, facilite la prise de sons. C’est un travail de comédien, et même de comédien de métier. Rien de tout cela, évidement, dans le documentaire (sauf rare exception). De toute façon, il faut allonger une perche au-dessus de locuteurs assez peu entraînés à parler pour le microphone. Mais cela ne suffit pas : l’environnement peut interférer. Il faut encore rechercher une ambiance calme (le silence est rare sur le grand plateau du réel), et même une bonne acoustique (a minima, pas trop gênante). Ou alors enregistrer en plein air, sans trop de bruits à l’entour… Toutes choses contraires à l’improvisation, au vécu spontané… Et si la prise de son « directe » n’était qu’une utopie, face à l’audition naturelle ?

Détour par le concert

Dans la salle de concert, l’auditeur se trouve placé à bonne distance (une quinzaine de mètres) de l’orchestre, et cependant l’écoute est claire, esthétiquement plaisante. Les timbres sont suffisamment fondus, sans être noyés, les solistes se détachent de l’accompagnement, la réverbération donne sa plénitude au son. Et pourtant, à une telle distance, les deux tympans reçoivent principalement les ondes venues des parois de la salle et secondairement l’onde directe, minoritaire, venue du podium. Le mélange tympanique est de la sorte dominé par les ondes indirectes, en retard sur l’onde première. On ne devrait entendre qu’un son cafouilleux, brouillé, fortement réverbéré et flou. De fait, le grossissement (G), qui mesure le rapport entre l’énergie directe et l’énergie indirecte (réactive) rabattue par les murs, est très petit.

G = direct / indirect = 13.8 V / 4 π c d2 T

avec V = le volume de la salle en m3 ;

T = le temps de réverbération en secondes ;

d =la distance aux pupitres en mètres ;

c = la vitesse du son.

Ainsi, un auditeur placé à 12 mètres des solistes dans la célèbre Grosser Musikverein de Vienne (Tr= 2,2 s ; V= 14600 m3), reçoit 5 fois plus d’énergie indirecte (retardée) que d’énergie directe en provenance des sources (G=0,2). Les derniers pupitres, placés à 20 mètres, ne lui donnent en droite ligne qu’un vingtième de l’énergie reçue (G=0,05). Le fauteuil idéal se trouve donc placé bien au-delà de la distance critique (au moins cinq à six fois), distance pour laquelle onde directe et ondes indirectes égalisent leurs énergies (cf. Figure 1) en donnant un grossissement moyen (G=1). La balance de profondeur y est objectivement très déséquilibrée, le mélange diffus/direct très disproportionné. Il en va de même dans de nombreuses salles de concert, toutes aussi réputées. Mais qui s’en rend compte ?

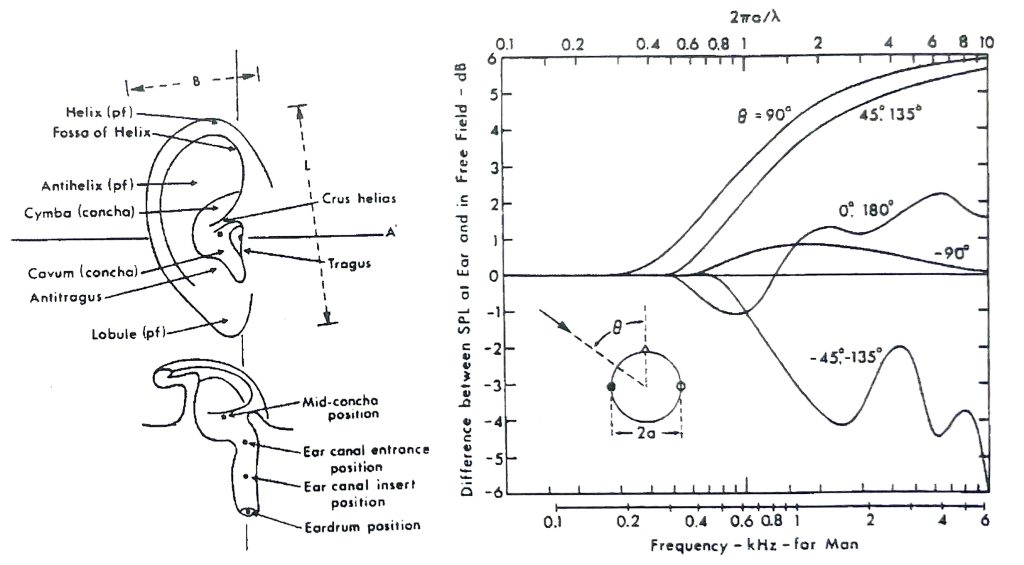

Figure 2

La distance critique

Niveau d’énergie directe et d’énergie indirecte dans une salle de concert, en fonction de la distance à la source (d’après Meyer).

Le plan moyen (G=1) est atteint quand les énergies directes et indirectes s’équivalent.

La distance critique apparente (pour un auditeur) est au moins cinq à six fois supérieure, compte tenu du pouvoir focalisant de l’appareil auditif.

L’auditeur continue d’écouter la musique sans se soucier de cette incroyable disproportion, au demeurant peu accessible à son entendement. Le traitement auditif, tel le battement de cœur, se fait tout seul, sans passer -cela se saurait-par la conscience. Le résultat s’impose comme naturel, directement issu des sources instrumentales.

Certes, le dispositif scénique, l’acoustique de la salle, la disposition des fauteuils (en gradins) jouent fortement avec l’écoute en s’accordant exactement à ses possibilités. L’auditeur le pressent, même s’il ne peut se l’expliquer tout à fait. Cela devient évident dès que l’acoustique, la disposition du podium ou des musiciens ne conviennent plus à la musique : salle trop petite ou trop grande, réverbération trop forte ou trop faible, instruments trop bruyants ou effectifs insuffisants. Cela s’entend immédiatement, et l’on en déduit que toute musique exige un réglage pointu quant à sa diffusion : un lieu parfaitement adapté, en termes d’acoustique architecturale, en termes de perceptibilité auditive. 4

En premier lieu, la scène orchestrale est placée face à l’auditeur-spectateur : il voit et entend les instrumentistes devant lui. C’est en effet en immobilisant continûment l’attention « droit devant » que se suspend la motricité corporelle, condition de tout spectacle ; c’est également dans le plan de front que l’œil réalise sa meilleure discrimination spatiale (une minute d’angle) et cela vaut pour le concert comme pour l’écran de cinéma, la scène de théâtre ou le tableau des peintres. C’est aussi frontalement que l’audition est la plus précise, la plus discriminante (2° d’angle). Von Békésy a dénommé cône de présence la région frontale de l’espace où l’oreille localise et sépare le mieux, lorsqu’elle s’associe à la vue.

Ce cône de présence — le cadrage auditif — contient et recouvre l’aire de balayage du regard, obtenue tête immobile quand l’œil explore le plan de front, tout en assurant une image correcte. Cette aire est relativement étroite, car la fusion des deux images rétiniennes (accordées point à point) exige la superposition exacte des pixels momentanément appariés ; ceci implique un réglage musculaire très pointu, et ce faisant, une obliquité modérée des deux axes visuels. Un regard trop de biais détériorerait la fusion cyclopéenne, le double pointage rétinien devenant trop difficile à réaliser de manière précise. Le cône de présence recouvre finalement la zone optiquement bonne, dessinée par un balayage oculaire préservant la qualité visuelle. S’il en est besoin, la tête tourne, entraînant dans un même mouvement les cadrages auditif et visuel.

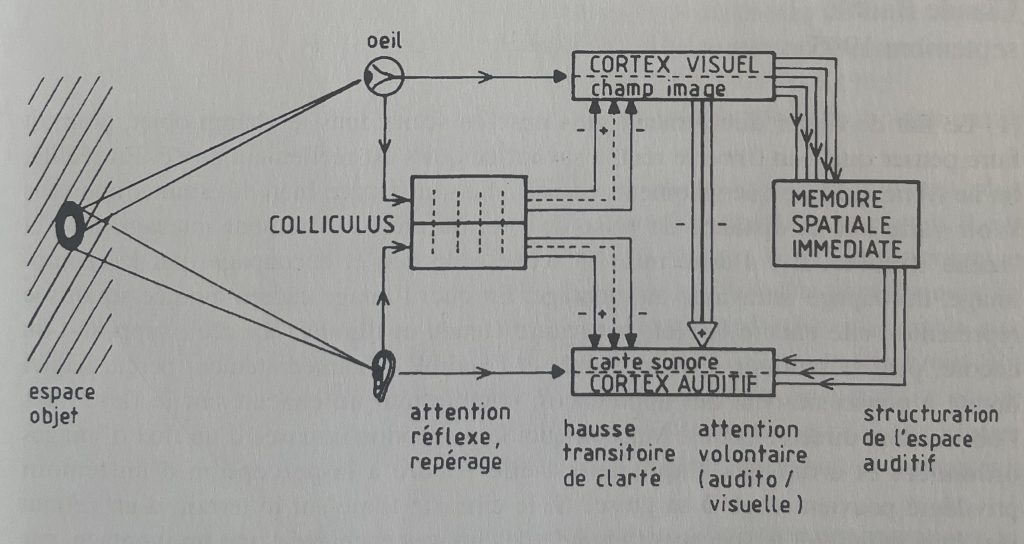

Figure 3

Le cône de présence

Le « cadrage auditif » serait préparé par une structure sous-corticale couvrant un large ovale (en +) tandis que le cône de présence s’étendrait à plus ou moins 20° droit devant, dans le plan de front.

Le microphone cardioïde « couvre » l’hémi-champ frontal, à plus et moins 90°.

D’après Buser et Imbert in « Audition », Ed Hermann, 1987.

L’inscription du regard à l’intérieur du cône de perception auditive indique clairement un champ d’appréhension focalisé vers l’avant, calqué de facto sur le champ d’action corporel : la vision, l’audition, la locomotion, la préhension font face aux objets qu’elles visent. Ainsi, l’attention visuelle et l’attention auditive fonctionnent en parallèle, de manière frontale et coaxiale, à l’intérieur d’un précadrage perceptif. Cela se lit dans les champs récepteurs (le territoire couvert par les neurones) des cortex de la vue et de l’ouïe. L’écoute droit devant, aidée par le regard, bénéficie alors d’une sélectivité accrue, d’un pouvoir séparateur augmenté.

Ne pouvant tout examiner en même temps, la perception a divisé l’espace auditif en deux parties : l’une frontale (cône de présence) où s’activent l’écoute et le regard, l’analyse fine et détaillée, l’attention soutenue ; l’autre périphérique, un peu effacée, atténuée comme telle dans la conscience, détachée comme ambiance peu présente. Ne s’y signalent que les mouvements, les bruits ou silences soudains. L’attention n’est attirée en fait que par les signaux transitoires, c’est-à-dire un changement, une fluctuation, une brusque modification. Quelle économie ! Les éléments inertes ou stationnaires — les plus nombreux — nous laissent de marbre, alors que tout ce qui bouge, craque, cliquette, grésille, tinte ou crépite, nous alerte fortement. Quelle efficacité, aussi ! Toute variation à l’entour attire l’attention sur elle, déclenchant une réaction d’orientation dans sa direction. Tout événement sonore muni d’un front d’onde abrupt constitue donc un point d’appel irrépressible, immédiatement écouté.

Cette répartition favorise le travail de l’attention frontale (neurones toniques, continûment actifs) sans pour autant abandonner le contrôle de l’environnement immédiat (neurones phasiques, omnidirectionnels, seulement sensibles aux changements, aux dérivées telles que dI/dt, dF/dt). La plupart des dispositifs scéniques — y compris le cinéma — sont du reste adaptés à la polarisation frontale du champ. Tout son « décentré » (porte qui grince, cellophane qui crisse, gens qui toussent) déclenche une distraction inutile, et parfois agaçante, parce que vide de sens, ou bêtement réflexe, non maîtrisable.

Ainsi se répartissent le in et le off dans la perception : le plan de front est à la fois très précis et très « présent », tandis que la périphérie reste floue, indistincte et relativement amorphe, peu « présente » dans la conscience. Cela veut dire qu’au concert, la réverbération réelle (périphérique) est fortement atténuée, qu’elle se signale peu à l’entendement, alors que la scène frontale est investie des pouvoirs discriminants de l’oreille et de l’œil. Au total, le précadrage auditif privilégie la scène en pondérant l’acoustique de la salle.

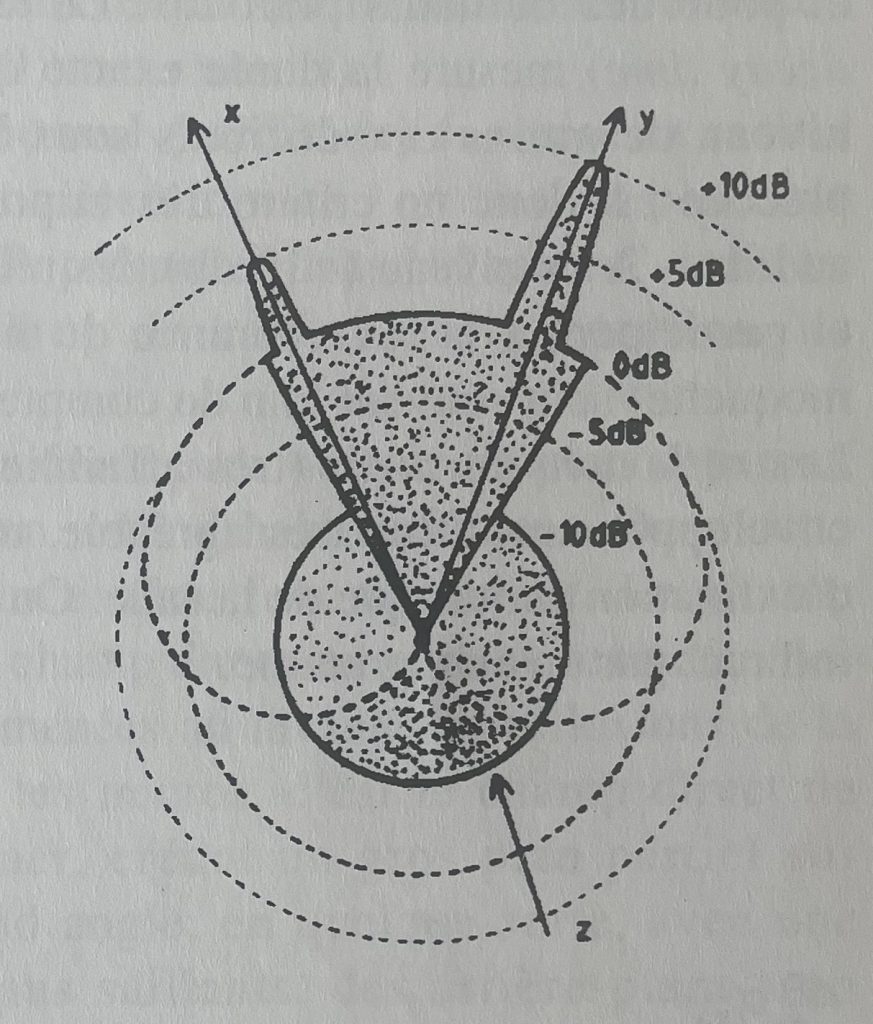

Figure 4

Le cadrage auditif

En z, l’inhibition statique du champ périphérique.

En x, la hausse transitoire de clarté.

En y, hausse supplémentaire de l’intelligibilité due au pointage visuel et auditif.

Les gains (dB) ne sont que des ordres de grandeurs. En pointillés, la courbe de directivité d’un cardioïde.

En second lieu, l’acoustique des salles est soigneusement étudiée : elle se fait surtout entendre à travers les réflexions précoces, celles qui surgissent dans les 40 premières millisecondes, juste derrière le son direct. En effet, ces réflexions — les plus énergétiques — ont la propriété de se résorber dans l’onde initiale, de fusionner avec elle, et donc de faire corps avec la source, tout en participant grandement (à 90%, sinon davantage) à la sonorité. Ces réflexions hâtives sont en fait additionnées (5) à l’onde directe, pour former le timbre apparent, tout en contribuant malgré tout au sentiment d’enveloppement sonore. Autrement dit, nous n’entendons pas le timbre instrumental, mais plutôt le timbre moyen réfléchi par la salle, c’est-à-dire l’énergie ramenée précocement par les murs (6). Néanmoins nous continuons à localiser les sources selon leur provenance, à même le podium (loi dite du premier front d’onde ; Cremer, 1948). C’est l’effet d’antériorité, précisé par Haas en 1951.

Les réflexions secondes (de 50 à 1500 millisecondes), détachées comme telles, participent au contraire à la confusion et au masquage son sur son : une série d’images floues en surimpression sur l’image nette. Même si elles se trouvent atténuées par le précadrage auditif, il importe que leur niveau soit suffisamment bas pour ne pas perturber la clarté apparente. C’est le cas dans les bonnes salles de concert, en forme de « boîte à chaussures », assez vastes et pourvues de hauts plafonds. Le temps de décroissance précoce (early decay time) mesure la durée exacte que met le son indirect à atteindre un niveau de moins dix décibels sous l’original. La pente de décroissance précoce est donc un critère très important d’intelligibilité sonore, de clarté auditive. À ce niveau (-10 db), les réflexions secondes sont moins gênantes et participent à la réverbérance du lieu. Les salles polyvalentes (béton et moquette) sont souvent loin du compte.

Les réflexions tardives (très affaiblies) ajoutent à la musique un halo, un enveloppement diffus très agréable, une couleur qui correspond au spectre d’extinction acoustique de la salle. On peut représenter l’ensemble du champ indirect par un échogramme.

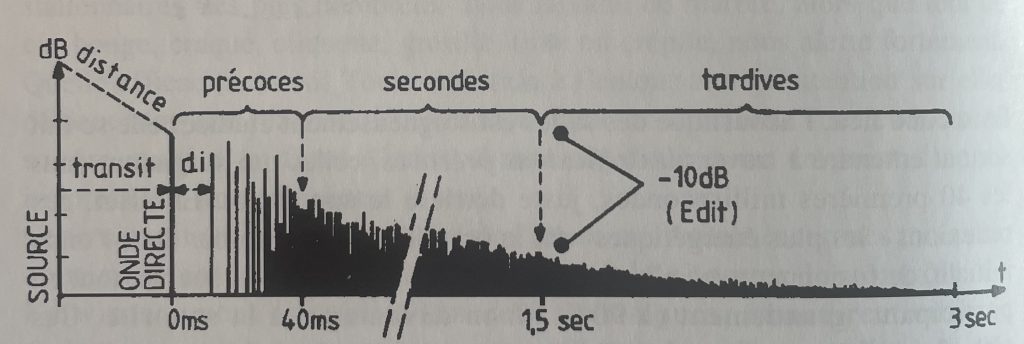

Figure 5

Échogramme d’une salle

Après un temps de transit, l’onde directe atteint l’auditeur (premier front d’onde) ; suit le délai avant la première réflexion précoce (délai initial) aussitôt complétée par ses semblables (jusqu’à 40 millisecondes), toutes fusionnées sur le premier front d’onde. Viennent alors les réflexions secondes (jusqu’à 1500 millisecondes) suffisamment décroissantes… (-10 dB, selon le EDT/temps de décroissance précoce) pour ne pas être gênantes et enfin les réflexions tardives de la réverbération (jusqu’à 3 secondes et plus).

Que se passe-t-il lorsqu’on implante un microphone à la distance d’écoute ? Le timbre est bon, mais comme noyé dans une caverne, pris dans une réverbération excessive. La sélectivité spatiale du microphone ne recopie ni le cône de présence (environ un trentième de la sphère omnidirectionnelle), ni l’atténuation périphérique (les 29/30es restants).

Concrètement, le microphone directionnel (cardioïde) favorise la moitié (quinze/trentième) de l’espace omnidirectionnel, en lieu et place du un/trentième sélectionné par le « cône de présence » dans la « sphère » auditive. Le champ indirect domine : il y a trop de halo, de réverbération, de brouhahas.

Il faut alors rapprocher le micro du podium pour obtenir un plan apparent, une perspective proche de ce que l’on entend habituellement. Dans cette manœuvre, la balance de profondeur évolue favorablement. Le champ indirect se trouve réduit, tandis que le champ direct est comme revitalisé : les ondes venues des instruments sont amenées au niveau des réflexions de la salle. Mais si l’on approche encore les micros, c’est le champ direct de quelques instruments qui va dominer, créant un gros plan partiel sur l’orchestre : une perspective au grand angle, en quelque sorte, avec une profondeur exagérée : des avant-plans saillants, des arrière-plans trop lointains. Le pouvoir séparateur du microphone – par pure proximité avec telle ou telle source — va alors ruiner l’impression d’ensemble, en favorisant un timbre ou des détails que l’oreille ne retient pas d’ordinaire, puisque masqués par l’éloignement, ou par l’alliage des sonorités. On doit placer les capteurs suffisamment loin pour éviter ce type de distorsion. Mais ceci n’est possible que dans une salle acoustiquement adaptée.

Cependant les premiers plans seront encore trop nets, les arrière-plans trop flous, comme dans une perspective « accélérée ». C’est que l’énergie directe décroît avec le carré de l’éloignement (1/d2), alors que l’énergie indirecte (réverbérée) reste à peu près constante. L’étagement des plans sonores dans la distance suit alors la décroissance de l’énergie directe, et cela entraîne un espace « dilaté » avec des « fuyantes » trop rapides, sans rapport avec celles de la vision (en 1/d) (7). La profondeur de champ (ou d’égale mise au point) est donc très courte, elle ne peut couvrir toute la profondeur du champ (le podium), beaucoup plus importante. Il faut « tasser » la profondeur pour éviter l’étrange dilatation spatiale. À cet effet, on élève le couple microphonique afin de « comprimer » les distances, afin de réduire l’étagement sonore entre les premiers et les derniers pupitres.

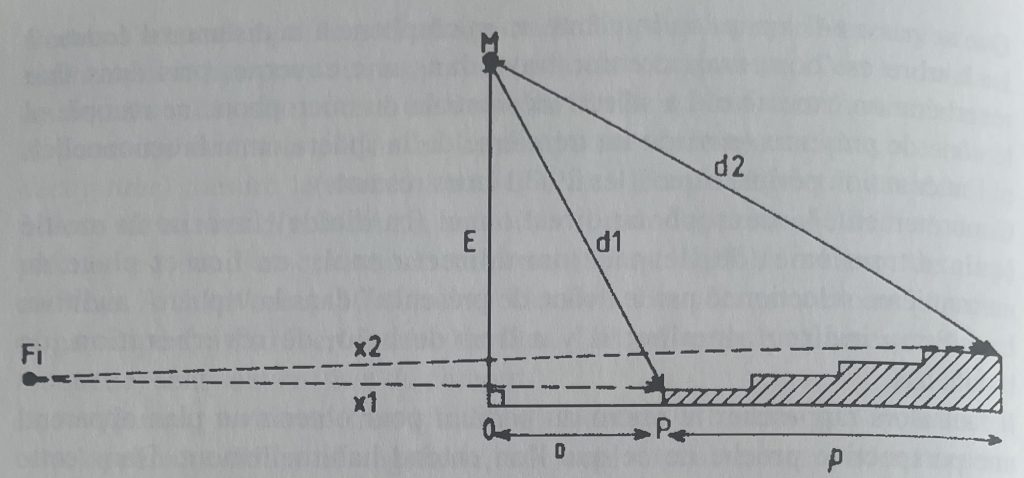

Figure 6

La perspective retrouvée

L’élévation (E) des micros (M) au-dessus du podium (p) réduit l’écart de distance (d2-d1) entre les premiers et derniers pupitres. Une implantation au « fauteuil idéal » (x2-x1) donnerait une perspective au grand angle, tandis qu’une « vue de dessus » donnerait une perspective trop « tassée ». La profondeur de champ (d’égale mise au point) est de toute façon très courte, à savoir : le vingtième de la distance critique… la bien nommée.

On peut aussi pratiquer la prise de son multimicros, en proximité. La balance sera faite plus tard, au mixage, et on ajoutera de la réverbération naturelle (micros lointains) ou numérique (processeur temporel). Avec le risque de dénaturer tous les timbres et de les nimber d’espace artificiel. Le gros plan pose de toute façon de nombreux problèmes.

En champ rapproché, le microphone capte surtout les ondes directes émises par l’instrument. Dès lors, la captation est soumise au rayonnement inhomogène de l’émetteur sonore (rayonnement anisotrope). La plupart des instruments rayonnent en effet différemment leurs « formants » selon la note jouée, distribuant inégalement l’énergie (grave, médium, aigu) dans les différentes directions de l’espace. Captées d’un seul point, certaines notes « aboient », deviennent « criardes » ou au contraire paraissent « en retrait » comme détimbrées. Le microphone – quasi ponctuel — ne capte donc qu’un timbre accidentel, tributaire de l’énergie disponible en ce point.

De cette manière, le son capté pourra paraître juste dans un certain registre, tout en sonnant faux dans un registre voisin. D’une octave à l’autre la sonorité change, et l’auditeur ne peut plus reconnaître l’image familière et stable à laquelle il s’est accoutumé, à savoir l’image-poids de l’instrument, image venue — pour l’essentiel — des réflexions précoces (0 à 40 millisecondes) de salle. La salle intègre en effet l’énergie rayonnée — de tous côtés –par les instruments, avant de la renvoyer -timbre moyen apparent (8)-aux oreilles des auditeurs. Le timbre apparent se relie ainsi, par le biais des premières réflexions, au rayonnement omnidirectionnel de l’instrument. Ces réflexions, énergétiquement puissantes, fusionnent avec l’onde directe, formant la véritable couleur instrumentale.

Le microphone, placé dans le champ rapproché, ne recueille qu’un timbre « local » collé à l’onde directe. Certes, on peut toujours espérer qu’en plaçant le microphone d’une manière très étudiée, il va peut-être se trouver un point de capture, un « angle d’attaque » favorable proche du timbre de référence, mais rien n’est moins sûr. Pour quelle raison, en effet, devrait-t-il exister une zone de rayonnement privilégiée, un axe subtil collectant convenablement toutes les notes, alors que l’instrument varie en directivité depuis le grave jusqu’à l’aigu ? Par quelle astuce une captation ponctuelle de proximité pourrait-elle intégrer la sonorité apportée par les réflexions de la salle, lesquelles nous renvoient, filtré, le rayonnement complet (multidirectionnel) des instruments ?

La captation de proximité est donc toujours un compromis, assorti généralement d’un filtrage à la console, filtrage à la recherche d’une image plausible, proche du timbre moyen apparent. De plus, le rapprochement du microphone met en lumière les bruits instrumentaux, les transitoires mécaniques que l’éloignement ordinaire estompe ou efface. Le contraste est augmenté, le grain est accentué, la dynamique aiguisée. Le gros-plan affirme donc une rupture avec l’image acoustique de référence, et pour certaines musiques ce sera l’occasion d’exprimer une sonorité instrumentale particulière (accroissement du détail, hyperprésence, timbre rechargé…), spécifique de la musique électrifiée (électro-instrumentale, pour être exact) largement dominante dans le domaine des « variétés ». Certains instruments ne sont connus du reste qu’au travers du micro, lequel fonde l’image de référence.

Figure 7

Le timbre « accidentel » ou « local » du violoncelle ne ressemble en rien au « spectre moyen » donné par les réflexions précoces de la salle (d’après Benade et Meyer).

Et surtout, la balance reste entièrement à refaire. L’enregistrement multimicros brise de facto le mixage acoustique naturel, l’impression d’ensemble ; il faut donc reconstituer la scène musicale voulue par le compositeur, avec ses alliages de timbres, tout en rendant justice à l’interprétation, avec ses nuances, sans trahir outre mesure l’acoustique donnée par la salle. Le mixage constitue donc une étape délicate où le sens musical, la sensibilité auditive entrent en jeu au même titre que le savoir procédural, la mise en espace et en niveaux.(9)

Tel est le dilemme du preneur de son : d’assez loin, le timbre est bon (s’y agglutinent les réflexions précoces données par la salle) mais le plan sonore est mauvais (il y a trop de réflexions secondes, insolubles dans l’onde directe) ; de plus près, le plan sonore devient plausible (la balance de profondeur est retrouvée), mais le timbre est étrange, instable (perturbé par le mouvement des musiciens, par l’émission directionnelle des instruments).

C’est à l’oreille — une oreille affûtée — que se régleront donc les divers compromis adaptés spécifiquement au volume orchestral, au genre musical, au rendu final de la scène mono ou stéréophonique.

Retour au direct

Le réel — on s’en douterait — n’est pas une salle de concert acoustiquement apprêtée. Ni même un désert immobile et silencieux. Lorsque le preneur de son aborde un enregistrement, il se trouve confronté avec ses micros à divers types de situations, aux acoustiques et environnements variés. Néanmoins les artefacts de la monophonie restent les mêmes à peu près dans tous les cas.

Il s’agit tout d’abord d’atteintes aux mécanismes de stabilisation du monde auditif, soit une altération des constances perceptives.

D’entrée de jeu, la perspective mononophonique accentue l’effet de profondeur : quelques mètres en arrière et l’on passe du gros plan au plan d’ensemble, du précis au flou, du gros son au petit son. L’œil ne stabilise plus les données auditives en lui appliquant ses propres critères spatiaux, à savoir la perspective géométrique (la décroissance en 1/d, plus lente que celle en 1/d2) et aussi bien, la perspective aérienne (relativement compensée).

Ainsi, la constance de volume est perturbée : le déplacement minime d’une source modifie grandement son niveau apparent, sans rattrapage possible. Rappelons que le niveau apparent est lié à l’énergie des réflexions précoces, peu variable, alors que le microphone de proximité a surtout affaire à de l’énergie directe, immédiatement dépendante du carré de la distance (1/d2 et non pas 1/d). Les « fuyantes » microphoniques ressemblent de la sorte à celles du grand angle, lesquelles réalisent la fameuse perspective accélérée. Aussi le perchman doit suivre continûment la source à une distance égale (et assez rapprochée) s’il veut garder la stabilité en niveau. Cela se joue à quelques centimètres ou décimètres près.

De la même façon, la perspective aérienne (le champ diffus, le brouillard des réflexions secondes et tardives) se trouve amplifiée par la captation monophonique. La profondeur d’égale netteté (ou latitude de point) est donc très faible devant un microphone, alors qu’elle est plutôt importante devant un objectif de caméra. Le perchman doit encore travailler à distance constante (ou presque) pour conserver la continuité du plan sonore, ce qui l’oblige à suivre tous les déplacements et à corriger les fluctuations de la distance source-microphone.

La constance de timbre est également altérée, pour les mêmes raisons : le rapprochement du capteur (pour cause d’intelligibilité) induit un timbre accidentel (local) au détriment du timbre de référence (global). Encore faut-il garder ce timbre à peu près constant, quelques soient les mouvements de l’émetteur. Un simple mouvement de tête et la voix change de sonorité, perd ses consonnes ou sa clarté ! Il faut donc prévoir ces mouvements, anticiper leur survenue, trouver l’emplacement/déplacement du micro ou même l’axe de rotation de la perche permettant — d’un simple mouvement de poignet — de récupérer instantanément le plein timbre recherché.

Mais il y a plus. Et plus difficile encore. La monophonie, on l’a vu, modifie totalement le rapport figure/fond. Faute de focalisation vraiment sélective, le microphone recueille au moins la moitié de la sphère auditive (10). Et faute de spatialisation véritable, le haut-parleur concentre cet hémi-champ encombré en un hublot… surencombré ! Ce faisant, l’ambiance enregistrée paraît énorme, démesurée, face à l’ambiance entendue directement, laquelle semble exister à sa vraie place.

Les sons imprévus, les événements furtifs, à peine retenus par l’attention passagère, envahissent ainsi le tunnel monophonique. Passage de mobylette, démarreur de voiture, avion haut dans le ciel, bruits de circulation prennent des allures monstrueuses, inimaginables par le profane, habitué aux bandes sonores bien faites. Impossible d’affaiblir ou de trier tous ces bruits : il manque l’information spatiale qui permettrait au cerveau de les marginaliser (cf.cadrage binaural). Le masquage et la confusion qui en résultent obligent à refaire la prise, à organiser un certain silence, ou alors à changer de lieu. De la même façon, la réverbération, les bruits lointains, agréables à écouter, se changent souvent en bruit de fond engluant et fatigant. Il faut alors rechercher des lieux ou des situations aptes à préserver la clarté de la figure, par rapport à un fond devenu envahissant, « impossible » en prise de sons (11). Et ajouter au mixage, à dose calibrée, les autres sons dont on a besoin. D’où la prise de sons fractionnée.

Figure 8

Tableau d’intelligibilité selon la norme AFNOR NF S 31 047

Les distances sont mesurées de la bouche du locuteur à l’oreille de l’auditeur.

Avec la monophonie, la situation se dégrade sensiblement… (une quinzaine de décibels).

| Niveau perturbateur de l’intelligibilité | Distance maximale pour la voix normale | Distance maximale pour la voix élevée |

| 35 db | 4 m | 15 m |

| 40 db | 2 m | 10 m |

| 45 db | 1,5 m | 6 m |

| 50 db | 1 m | 4 m |

| 55 db | 0,5 m | 2 m |

| 60 db | 0,25 m | 1 m |

| 65 db | 0,20 m | 0,75 m |

| 70 db | – | 0,50 m |

| 80 db | – | 0,25 m |

Cependant, même lorsque les conditions favorables sont réunies, quelques surprises sont encore à venir. Un son à front raide, impulsionnel, appelle sur lui une hausse transitoire de clarté, une mise en relief momentanée (quelques centaines de millisecondes, voire plus), tandis que dans le même laps de temps, le son « utile » — telle la parole — est abaissé au niveau amorphe du bruit de fond ambiant (masque-réflexe). Le transitoire d’attaque acquiert un mordant, une lisibilité qui submerge les sons avoisinants. C’est ainsi qu’enregistrant une conversation à table, on entendra incroyablement les bruits de verres et de fourchettes (instantanément haussés) et médiocrement les dialogues (corrélativement muselés), pour la simple raison qu’ils se superposent à la voix, émanant d’un seul et même point origine : le haut-parleur. L’étalement spatial permettrait de détacher la voix (écoutée) des bruits (entendus, mais pondérés). Le tunnel monophonique la fait passer en perspective inverse, l’accrêtement affectant les transitoires de type percussif, au détriment des sons à profil plus harmonieux.

Dans le même ordre d’idées, le chevauchement d’un bruit « utile » (claquement de portière, vaisselle, cellophane, etc.) et d’une réplique est plutôt délicat : on risque de perdre un mot important, ou une partie du texte, si le bruit se prolonge. Il faut alors « traiter » le bruit en le pondérant passivement (feutrines, amortisseurs) ou activement jeu retenu, mezzo-forte, piano). On peut aussi reprendre immédiatement en son seul (hors-caméra) le mot ou la phrase évaporée : à ajuster lors du montage et du mixage.

Le tunnel monophonique avantage tant les transitoires, le bruit ambiant, l’acoustique des lieux, que toutes sortes de précautions instrumentales restent indispensables. Sans elles, le « réalisme » auditif serait inévitablement rompu… Et si la prise de son « directe », improvisée, discrète, n’était qu’une utopie ? (bis).

Détaillons pour finir trois types de situations couramment rencontrées :

les extérieurs

Le plein-air est rarement mat : de nombreux obstacles réfléchissants (arbres, murs, maisons) ajoutent leur acoustique particulière, ce qui fait la diversité des atmosphères. Échos lointains, réflexions proches, acoustiques couplées, résonances de cour intérieure en passant devant un portail ouvert, changement de sol…, la liste est longue. Et surtout le plein air est rarement silencieux : le bruit de fond urbain est lourd en graves, riche en événements perçants — klaxons, camions, mobylette — non refoulés par le microphone. Le risque de chevauchement par des sons imprévus (masquage son sur son) ou par des bruits superflus (ils ne le sont pas tous, mais cela arrive souvent), par des bruits impulsionnels à fort pouvoir couvrant, est permanent. Reste à différencier la pollution sonore, empêcheuse de tourner en son, envahissante ou extérieure au propos du film, d’avec le décor sonore plus ou moins adapté aux conditions de tournage, décor qui parfois réserve quelques bonnes surprises.

Il faut veiller toutefois à ce que le niveau moyen du bruit ambiant reste assez bas au-dessous du son principal (10 dB seraient un minimum), en orientant éventuellement la zone inerte du microphone vers le côté le plus bruyant du « décor », ce qui exige un placement ad hoc de la caméra. Reste que la perche n’est pas discrète, et qu’elle n’autorise guère les plans larges, sauf à cacher le (ou les) microphone d’appoint, s’il y en a.

les grandes salles

La perspective aérienne (accélérée) est ici la difficulté principale. Non traités acoustiquement, le hall de gare, la piscine, la grande poste, le restaurant, etc. sont généralement impraticables. De grands panneaux absorbants (suspendus ou posés) atténuent le champ indirect des ondes sonores, tant à l’aller (vers les parois) qu’au retour (vers le microphone). Des couvertures, des tentures, posées à quelque distance des murs (hors du champ), améliorent l’EDT (early decay time), si important dans le masquage son sur son. Mais peut-on encore parler de son direct ? Combien de temps faut-il, du reste, pour installer un tel traitement ? Et quel est le recul microphonique disponible pour les plans larges, justifiant un tel « décor » ?

Le bruit ambiant est un autre type de difficulté. Le plus souvent il interdit tout bonnement la prise de sons. Bruits des pas, brouhahas, rumeur épaisse, son « bouché ». Dans les films de fiction, on fait jouer « en muet » les nombreux figurants recrutés pour la circonstance. Il n’en est guère question dans le « cinéma du vécu ». La vie sociale, dans les lieux publics, est déjà mise en scène par ses déterminations propres. On ne saurait faire taire une foule, une assemblée mobile de passants ou de visiteurs.

C’est alors qu’on a recours, comme dans certaines situations de plein air, au microphone-cravate.

Ce capteur miniature, convenablement placé sur les personnes (attention aux bruits de vêtements, à la fiabilité de la fixation) permet de sauver la situation. Le timbre est inexact, mais l’intelligibilité est retrouvée. Le problème est que l’on à affaire à une grosseur de plan unique, avec toujours la même texture, la même coloration inhérente à l’emplacement microphonique (timbre accidentel très particulier) et aussi à la « bosse de présence » aménagée dans la bande des aiguës (6 à 10 khz). Sans parler des raccords de sonorité et de dynamique entre la perche et le dit cravate. On va vers une perception paradoxale : à la fois précise (quoique détimbrée) et large, ouverte à la salle. Un bi-plan ? Un enregistrement sur deux pistes séparées permettra de doser ultérieurement le poids respectif des deux micros, face à l’image montée, avec ajout éventuel d’autres sons.

Il n’empêche. Outre que ce dosage est délicat, des problèmes de phasing interviennent fréquemment. Le son de la voix étant capté par deux microphones assez voisins, les deux signaux vont interférer lors de leur mixage électrique. La perche, plus éloignée, reçoit la voix avec un petit retard (3 millisecondes par mètre d’écart). Les deux signaux, de valeurs assez proches, vont se superposer avec un petit décalage, provoquant un filtrage en peigne (suite d’extinctions à différentes fréquences) (12). Ce filtrage en peigne provoque une importante altération du timbre. En outre, si cet écart varie au cours de la prise (mouvement de la perche ou de la personne), s’ajoute alors un glissement de peigne, tout à fait audible, appelé phasing.

Le cravate HF (sans fil) fonctionne de la même façon. Bien que fort pratique et fort discret, il apporte de nouveaux problèmes. L’émetteur contient en effet un compresseur-limiteur chargé de calibrer le signal pour l’émission, tandis que le récepteur HF renferme un « décompresseur » dont rien n’indique la rigoureuse symétrie de fonctionnement. La dynamique du son est de toute manière perturbée par le réglage automatique de niveau installé à même le boîtier émetteur. Par ailleurs, la propagation des ondes radio-électriques n’est pas à l’abri d’interférences destructives, de fadings momentanés, surtout en présence de structures métalliques. Un souffle, un décrochage peuvent entamer la continuité de l’enregistrement.

les petites salles

Un petit local, comportant des parois parallèles, semi-réfléchissantes, est un résonateur à trois dimensions (HXLxP), entretenant des colorations insistantes, qui dépendent de ses dimensions. Les ondes sonores s’y prolongent d’autant plus longuement que les parois sont proches et peu absorbantes (salle de bains, cuisine, local en béton peint..etc..). Le traînage acoustique qui en résulte est connu sous le nom de réverbération. Un tel traînage est partiellement rejeté ou en tout cas pondéré par le cadrage auditif, en sorte que la gêne ressentie est souvent minime. Le microphone ne l’entend pas évidement de cette oreille.

En réalité, ce n’est pas tant à la réverbération qu’il faut s’intéresser, mais au poids relatif des réflexions secondes (40 à 1500 millisecondes), les plus gênantes en prise de son. L’énergie réfléchie doit descendre assez vite à moins dix décibels sous le son utile, afin d’éviter le brouillage, la « pâtée » sonore. La décroissance rapide de ces réflexions est indispensable à la clarté de l’enregistrement. Cela est plutôt rare, car les acoustiques sont conçues pour l’oreille et non pour le microphone. Là encore il est souhaitable d’envisager un traitement spécifique (hors champ !), notamment entre les deux parois les plus proches, et donc les plus « réactives » (assez souvent sol et plafond). Il est également possible de traiter les angles et les coins où se renforcent les fréquences basses. L’avantage du traitement acoustique est de permettre un meilleur recul microphonique et d’échapper ainsi au gros plan serré.

De plus, l’acoustique réelle varie beaucoup d’un point à un autre à l’intérieur d’une pièce de petites ou moyennes dimensions. Lorsqu’une personne se déplace, et avec elle la perche, le micro peut s’approcher d’un coin ou d’une paroi, ce qui modifie la sonorité de la voix, par une sorte d’effet de cavité. Il faut se rappeler que le micro reflète l’état pressionnaire en un point donné de l’espace, et non le timbre apparent. C’est ainsi que les pics et les crevasses des ondes stationnaires engendrées par les parois parallèles participent à la prise de sons. En choisissant opportunément l’emplacement de la source, et ce faisant du microphone, on évite certains renforcements dans le grave, on redonne de l’intelligibilité au texte.

Figure 9

L’écoute intelligente associe vision en relief et audition binaurale. Elle est impossible en monophonie. On la simule grâce au mixage, en rétablissant au potentiomètre la perspective attentionnelle (le rapport figure/fonds).

Quoi qu’il en soit, il est prudent de détecter les zones « interdites », les zones où le son devient cafouilleux, confus ou même trop différent en sonorité : comment le raccorder ensuite d’un plan à l’autre ? Comment lui redonner la continuité nécessaire ?

Malgré toutes ces difficultés, de nombreux documentaires réussissent leur son « direct ». De nombreux ingénieurs du son contournent les difficultés acoustiques, pallient les insuffisances de la monophonie. Des procédures instrumentales précises viennent à bout d’obstacles difficiles. Un film comme Le cycle du serpent, de Thierry Michel, nous paraît un bon exemple de cette réussite.

Néanmoins, il reste beaucoup à espérer de systèmes plus évolués que la monophonie, systèmes qui permettraient, d’une part, au spectateur d’exercer à nouveau ses facultés auditives, d’autre part, au preneur de sons d’échapper à quelques contraintes techniques, ce qui donnerait accès — sans trop d’acrobaties instrumentales — à des sons réputés imprenables.

Le cinéma direct pourrait alors mériter davantage son appellation.

Claude Bailblé, septembre 1995

- Le fait de filmer directement, sans mise en scène dans le champ-objet, pourrait faire penser que l’on filme le réel, à savoir : ce qui s’est réellement passé. En réalité, on ne filme que quelques moments choisis, dans un espace bien déterminé, non sans avoir varié axe et distance de prise de vue, ou même fortement interagi avec la « scène » filmée… Il y a donc mise en scène — sélection et découpage — par le champ-image, découpage retravaillé au montage. En quoi l’image cadrée-montée-sonorisée représente-t-elle encore le réel, par nature étendu et illimité ? Le réel, suppose-t-on encore, peut se montrer dans le visible et l’audible, l’immédiatement perçu, lequel donne à penser au-delà des apparences, comme tout un chacun sait le faire dans l’observation directe. Certes ! Mais en quoi la perception imposée d’un flux d’images ordonnées et arrangées s’apparente-t-elle encore à la perception d’un témoin privilégié pouvant réagir à sa guise ? Si le cinéaste filme sur le terrain d’un certain réel (très délimité), le spectateur regarde des images enchaînées par un montage, par une pensée en mesure d’exprimer un point de vue (celui du cinéaste) sur une réalité particulière, cueillie de manière dispersée… mais rassemblée — hors de tout réalisme perceptif — par le flux continu de la projection.

- Sans doute l’effacement de l’appareillage technique renforce-t-il la transparence de la scène, invitant le spectateur à se considérer comme le témoin direct de l’action ou — à tout le moins — comme le coproducteur immédiat du sens.

- On verra par la suite qu’il n’en est rien : la prise de son rapprochée (0,30 à 1m) est toujours un compromis. Placé à une distance critique — cf. infra — le microphone enregistre une image plausible essentiellement en termes de plan sonore.

- On lira avec intérêt l’ouvrage Architecture et musique de Michael Forsyth, Ed Mardaga, Bruxelles, 1985, à propos des qualités requises pour les salles de concert : l’impression de volume spatial, le relief, la clarté, l’amortissement, la texture, la diffusité et la couleur sonore. On y notera en particulier le rôle des réflexions latérales précoces dans l’impression de plénitude sonore.

- L’addition « transparente » de ces réflexions sur l’onde directe évite la prise en compte de nombreuses sources fantômes renvoyées par les murs environnants, et de ce fait, localisées sur les parois. Quarante millisecondes constituent donc pratiquement « l’épaisseur du présent » auditif, épaisseur sans laquelle nous serions des « chauves-souris » assaillies d’échos rapprochés et, comme tels, spatialement détachés.

- Il n’y aurait rien de pire qu’une chambre sourde (anéchoïque) pour écouter un instrument ; le timbre y paraîtrait squelettique, dépourvu de chair, une sorte de figure noire et blanche posée sur un fond vide.

- La vision, plus précise spatialement, dirige l’audition. L’espace auditif (en 1/d2) est recodé dans l’espace visuel (en 1/d) afin d’assurer la cohérence de la perception. On ne saurait voir et entendre l’espace « emboîté » de deux manières divergentes…

- Cf les travaux d’Arthur Benade, dans le JAES Vol 33 n°4, avril 1985.

- Il faut retrouver les équilibres de niveaux, de timbre, de présence, voulus par le compositeur et assemblés par les interprètes.

- Seuls les microphones hyper-cardioïdes, plus directifs, avantagent plus clairement le plan de front, au moins dans les fréquences médiales et aiguës. Leur emploi est délicat, exige du métier, tant par l’habileté que par la qualité du pointage ou de la « visée » vers la source. Il est possible ainsi de s’affranchir partiellement de l’environnement acoustique, ou de d’obtenir un recul microphonique favorable aux plans larges. Encore que « le facteur de recul », à plan sonore égal, reste très limité. En prenant pour base le microphone omnidirectionnel, le cardioïde permet de se placer 1,7 fois plus loin, l’hyper-cardioïde deux fois plus loin, tandis que le microphone canon autorise un recul d’un facteur 3 environ. Cela ne peut évidemment se comparer à un zoom !

- L’importance des repérages n’est plus à démontrer… Attention aux variations du paysage sonore, d’une heure à l’autre, d’un jour à l’autre. À ce propos, lire ou relire Le paysage sonore de R. Murray Shafer, Ed JC Lattès, 1979.

- La fréquence de base des extinctions a pour demie longueur d’onde l’écart entre les deux micros.

Publiée dans La Revue Documentaires n°11 – Héritages du direct (page 72, 1995)